LiteLLMで実現する社内AIツールのAPIキー一元管理

はじめに

社内で複数のAIツールを導入する際、最も煩雑な課題の一つがAPIキーの管理です。ChatGPT、Claude、Geminiなど、各LLMプロバイダーから発行されるAPIキーを、部署ごと、プロジェクトごと、従業員ごとに管理するのは非常に手間がかかります。

よくある課題として、以下のような状況に直面することがあります。

- APIキーの分散管理: 各チームが個別にAPIキーを取得・管理し、全体の利用状況が把握できない

- コスト管理の困難さ: どのチームがどれだけAPIを使用しているか、リアルタイムで追跡できない

- セキュリティリスク: APIキーがSlackやメールで共有され、漏洩リスクが高まる

- 従業員の退職時の対応: 退職者が使用していたAPIキーの無効化漏れが発生

- プロバイダー切り替えの負担: 別のLLMプロバイダーに切り替える際、全てのツールの設定変更が必要

本記事では、クリエーションラインでの実践事例をもとに、LiteLLMを活用した社内APIキー一元管理の導入メリットと、段階的な導入アプローチを紹介します。コスト削減とセキュリティ強化を両立させながら、どのように社内のAI活用を推進していくか、その方針と得られた知見を共有します。

この記事を読むことで、以下を理解できます。

- LiteLLMによる統一APIインターフェースと一元管理がもたらすメリット

- Virtual Keyによるセキュアなアクセス管理の仕組み

- 試験導入から本番運用への段階的な移行方針

- コスト削減とスケーラビリティを両立させるアーキテクチャ選択

- 部署別・ユーザー別の利用状況可視化による効果的な運用

LiteLLMの基本概念

社内APIキー管理の課題

従来、各チームや従業員が個別にAPIキーを管理する方法では、以下のような問題が発生します。

従来の方法の例(分散管理の課題)

Plaintext

開発チーム A ├─ OpenAI API Key (dev用) ├─ Anthropic API Key (prod用) └─ Google API Key (実験用) マーケティングチーム B ├─ OpenAI API Key (共有) └─ ChatGPT Plus (個人契約) データサイエンスチーム C ├─ Anthropic API Key (分析用) └─ Azure OpenAI Key (社内システム用)

この状態では、以下の問題が発生します。

- コスト把握の困難: 各チームの利用料金が個別請求され、全体像が見えない

- APIキーの重複取得: 同じプロバイダーのキーを複数チームが別々に取得

- セキュリティ管理の煩雑さ: APIキーの共有方法がチームごとにバラバラ

- ガバナンスの欠如: 誰がどのモデルを使用しているか追跡できない

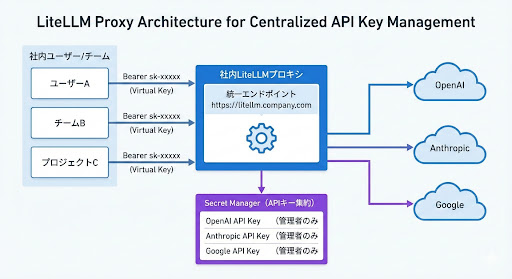

LiteLLMによる一元管理

LiteLLMをプロキシとして導入することで、APIキー管理を中央集権化できます。

LiteLLMプロキシ導入後のアーキテクチャ

一元管理のメリット

- 単一エンドポイント: 全社員が同じURLを使用

- Virtual Keyによる個別認証: 従業員ごとに固有のVirtual Keyを発行

- APIキーの秘匿化: 実際のプロバイダーAPIキーは管理者のみが知る

- 利用状況の可視化: 誰が何を使ったか全て記録

Virtual Keyによるセキュアなアクセス管理

LiteLLMのVirtual Key機能は、社内でのAPIキー管理を安全かつ柔軟にする重要な概念です。

Virtual Keyとは

Virtual KeyはLiteLLMが発行する仮想的な認証キーで、実際のプロバイダーAPIキー(OpenAI、Anthropic等)とは独立して管理されます。LiteLLM公式ドキュメントによると、Virtual KeysはLiteLLM Proxyへの認証に使用されるAPIキーで、利用状況の追跡やモデルアクセスの制御が可能です。

Plaintext

従業員が使用するVirtual Key: sk-litellm-user-yamada-abc123 ↓ LiteLLMプロキシ内部で変換 実際のプロバイダーAPIキー(Secret Manager管理): sk-ant-api03-xxx... (Anthropic) sk-proj-yyy... (OpenAI)

Virtual Keyの利点

| 利点 | 詳細 |

| セキュリティの向上 | プロバイダーAPIキーが従業員に露出しない |

| 柔軟なアクセス制御 | ユーザーごと、チームごとに権限を細かく設定可能 |

| 即座の無効化 | 退職者のVirtual Keyを即座に無効化(プロバイダーキー変更不要) |

| 利用状況の追跡 | どのVirtual Keyがどのモデルを使用したか完全に記録 |

| 予算管理 | Virtual Keyごとに月次予算を設定し、超過を防止 |

Virtual Keyの設定例

JSON

{

"key": "sk-litellm-user-yamada-abc123",

"user_id": "yamada.taro@company.com",

"team_id": "engineering",

"max_budget": 50.0,

"budget_duration": "30d",

"models": ["claude-sonnet-4.5", "gpt-4.1-mini"],

"metadata": {

"department": "開発部",

"cost_center": "R&D-001"

}

}

このVirtual Keyを持つユーザーは、月額$50の予算内で、指定されたモデルのみを使用できます。予算超過やモデル外へのアクセスは自動的にブロックされます。

統一APIインターフェースの利点

LiteLLMは、全てのLLMプロバイダーをOpenAI互換のAPIで統一します。従業員はVirtual Keyを使用して、単一のAPIフォーマットで全てのモデルにアクセスできます。

従業員が使用するコード(どのプロバイダーでも同じ)

Python

import openai

# 社内LiteLLMプロキシを指定

openai.api_base = "https://litellm.company.com"

openai.api_key = "sk-litellm-user-yamada-abc123" # 個人に発行されたVirtual Key

# OpenAI GPT-4.1を使用

response = openai.ChatCompletion.create(

model="gpt-4.1",

messages=[{"role": "user", "content": "資料を要約して"}]

)

# Anthropic Claude Sonnet 4.5に切り替え(モデル名を変更するだけ)

response = openai.ChatCompletion.create(

model="claude-sonnet-4.5",

messages=[{"role": "user", "content": "資料を要約して"}]

)

# Google Gemini 3 Flashも同様

response = openai.ChatCompletion.create(

model="gemini-3-flash",

messages=[{"role": "user", "content": "資料を要約して"}]

)

従業員側のメリット

- 学習コストゼロ: OpenAI APIを知っていれば他のモデルもすぐ使える

- ツール切り替え不要: 同じコードで複数のLLMを試せる

- APIキー管理不要: 個人で複数のプロバイダーと契約する必要なし

- Virtual Keyで安全: プロバイダーAPIキーを直接扱わない

管理者側のメリット

- プロバイダー切り替えが簡単: バックエンドのAPIキーを変更するだけ

- 段階的移行が可能: 新しいプロバイダーのテストを特定ユーザーで実施

- コスト最適化: 用途に応じて最もコスパの良いモデルに誘導

- Virtual Key管理: 退職者対応、予算超過防止が容易

サポートされるLLMプロバイダー

LiteLLMは、社内でよく使われる主要なLLMプロバイダーをサポートしています。

主要プロバイダー(2025年12月時点の最新モデル)

| プロバイダー | 最新モデル | 主な用途 | 公式ドキュメント |

| OpenAI | o3、o4-mini、GPT-4.1、GPT-4.1 mini、GPT-4.1 nano | 高度な推論、コーディング、汎用文章生成 | OpenAI Models |

| Anthropic | Claude Opus 4.5、Claude Sonnet 4.5、Claude Haiku 4.5 | コーディング、エージェント、コンピュータ操作 | Claude Models |

| Gemini 3 Flash | フロンティア級の性能、高速処理、低コスト | Gemini Models | |

| Azure OpenAI | Azure版GPT-4.1、GPT-4o | 既存Azure環境との統合 | Azure OpenAI |

| AWS Bedrock | Claude、Titan等 | 既存AWS環境との統合 | AWS Bedrock |

モデル選択の参考情報

OpenAI(2025年12月)

- o3: 最も強力な推論モデルで、コーディング、数学、科学、視覚認識等でフロンティアを推進。o1比で20%少ない重大エラー

- o4-mini: 高速かつコスト効率の良い推論に最適化された小型モデル。AIME 2024と2025で最高性能

- GPT-4.1シリーズ: GPT-4oとGPT-4o miniを全面的に上回り、SWE-bench Verifiedで21.4%改善。最大100万トークンのコンテキスト対応

Anthropic(2025年12月)

- Claude Opus 4.5: 2025年11月24日リリース。「コーディング、エージェント、コンピュータ操作で世界最高のモデル」。料金は$3/$15 per million tokens

- Claude Sonnet 4.5: 2025年9月29日発表。「世界最高のコーディングモデル」。料金は$3/$15 per million tokens

- Claude Haiku 4.5: 2025年10月15日リリース。低レイテンシとコストに最適化された小型高速モデル。料金は$1/$5 per million tokens

Google(2025年12月)

- Gemini 3 Flash: 2025年12月リリース。Gemini 2.5 Proを上回る性能で3倍高速、コストは一部。SWE-bench Verifiedで78%達成。料金は$0.50/$3 per million tokens

使い分け例(2025年12月最新モデル対応)

YAML

# config.yaml - 社内用途に応じたモデル設定

model_list:

# コーディング支援用(開発チーム向け)- 最高性能

- model_name: claude-opus-4.5

litellm_params:

model: anthropic/claude-opus-4-5-20251124

api_key: "os.environ/ANTHROPIC_API_KEY"

# 高速コーディング用(開発チーム向け)- バランス重視

- model_name: claude-sonnet-4.5

litellm_params:

model: anthropic/claude-sonnet-4-5-20250929

api_key: "os.environ/ANTHROPIC_API_KEY"

# 高速応答用(カスタマーサポート向け)

- model_name: gpt-4.1-mini

litellm_params:

model: openai/gpt-4.1-mini

api_key: "os.environ/OPENAI_API_KEY"

# 複雑な推論用(データサイエンスチーム向け)

- model_name: o3

litellm_params:

model: openai/o3

api_key: "os.environ/OPENAI_API_KEY"

# マルチモーダル処理用(マーケティングチーム向け)

- model_name: gemini-3-flash

litellm_params:

model: vertex_ai/gemini-3-flash

api_key: "os.environ/GOOGLE_API_KEY"

# コスト重視の汎用用途(全社向け)

- model_name: claude-haiku-4.5

litellm_params:

model: anthropic/claude-haiku-4-5-20251015

api_key: "os.environ/ANTHROPIC_API_KEY"

キャッシュとロードバランシング機能

社内利用では、同じような質問が繰り返されることがよくあります。LiteLLMのキャッシュ機能により、APIコストを大幅に削減できます。

Redisキャッシングによるコスト削減

YAML

litellm_settings:

# Redisキャッシュ有効化

cache: true

cache_params:

type: redis

host: os.environ/REDIS_HOST

port: os.environ/REDIS_PORT

password: os.environ/REDIS_PASSWORD

ttl: 3600 # 1時間キャッシュ保持

効果の例

- 社内FAQ対応: 「経費精算の方法は?」などの頻出質問をキャッシュ

- キャッシュヒット率: 40-60%程度が期待できる(社内利用では高い傾向)

- コスト削減効果: 月額APIコストを30-50%削減可能

- レスポンス速度: 平均200ms → 50ms程度(キャッシュヒット時)

ロードバランシングによる可用性向上

複数のAPIキーやエンドポイントを設定することで、一つのプロバイダーがダウンしても自動的にフォールバックできます。

YAML

model_list:

# Claude Sonnet 4.5(メイン)

- model_name: claude-sonnet-4.5

litellm_params:

model: anthropic/claude-sonnet-4-5-20250929

api_key: "os.environ/ANTHROPIC_API_KEY_1"

# Claude Sonnet 4.5(フォールバック用の別APIキー)

- model_name: claude-sonnet-4.5

litellm_params:

model: anthropic/claude-sonnet-4-5-20250929

api_key: "os.environ/ANTHROPIC_API_KEY_2"

router_settings:

routing_strategy: simple-shuffle

fallbacks:

- ["anthropic/claude-sonnet-4-5", "openai/gpt-4.1"]

レート制限とクォータ管理

社内利用では、特定のユーザーやチームが過剰にAPIを使用することを防ぐ必要があります。Virtual Keyごとに細かい制限を設定できます。

Virtual Key別のクォータ設定例

| ユーザー/チーム | 月次リクエスト上限 | 月次予算 | 使用可能モデル |

| 開発チームA | 100,000回 | $500 | claude-opus-4.5, claude-sonnet-4.5, o3 |

| マーケティングB | 50,000回 | $200 | gpt-4.1-mini, gemini-3-flash |

| 個人ユーザーC | 10,000回 | $50 | gpt-4.1-mini, claude-haiku-4.5 |

これにより、予算超過を防ぎつつ、公平なリソース配分が可能になります。

アーキテクチャ設計と進化の経緯

クリエーションラインでは、LiteLLM環境の構築にあたり、段階的なアプローチを採用しました。

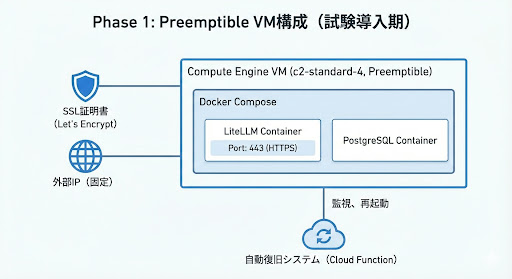

Phase 1: Preemptible VM構成(試験導入期)

導入の背景

- 低コストでの試験導入: 本格導入前にコストを抑えて検証

- 導入ハードルの低さ: Docker Composeで素早くセットアップ

- 柔軟な設定変更: VM上で自由に設定を調整可能

構成図

Preemptible VMの選択理由

| 理由 | 詳細 |

| コスト削減 | 通常VMと比較して70%のコスト削減 |

| 試験導入に最適 | 失敗しても損失が少ない |

| スピード重視 | インフラ構築が迅速(数時間で完了) |

| 柔軟性 | 設定変更が容易、試行錯誤が可能 |

課題と解決策

| 課題 | 解決策 | 結果 |

| 24時間以内の強制終了 | Cloud Function自動復旧システム | 稼働率99.9% |

| VM管理の運用負荷 | systemd自動起動、監視スクリプト | 深夜復旧で業務影響なし |

| スケーラビリティの限界 | Phase 2でサーバーレス移行を計画 | - |

自動復旧システム(高信頼性の実現)

Plaintext

1. VM Preemption検知(深夜に発生することが多い) ↓ 2. shutdown-script.sh実行 └─ LiteLLMサービスをグレースフル停止 └─ GCSにpreemption状態を保存 ↓ 3. Cloud Function起動(数秒以内) └─ VM状態をTERMINATEDまで監視 └─ Resource fingerprintエラー回避 ↓ 4. インテリジェントリトライ └─ 指数バックオフで最大5回リトライ └─ 成功率: 99.9% ↓ 5. VM再起動 → LiteLLMサービス自動起動 └─ 平均復旧時間: 2-3分

Phase 1の成果

- 試験期間: 2-3ヶ月

- コスト: 月額$165(VM $117.75 + Cloud SQL $11.07 + Redis $35.77)

- 稼働率: 99.9%

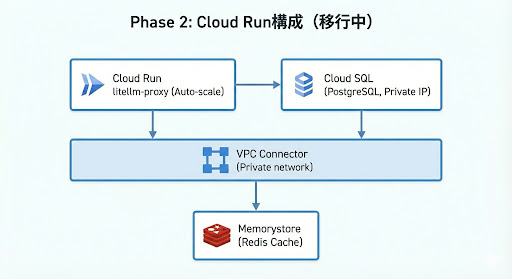

Phase 2: Cloud Run構成(移行中)

移行の背景

Phase 1での検証を経て、以下の理由でサーバーレス構成への移行を進めています。

| 移行理由 | 詳細 |

| コスト最適化 | 従量課金で夜間・週末のコスト削減 |

| スケーラビリティ | 利用者増加に自動対応 |

| 運用負荷削減 | VM管理、パッチ適用が不要 |

| 信頼性向上 | GCPマネージドによる高可用性 |

構成図

Cloud Run構成の特徴

- フルマネージド: サーバー管理が完全に不要

- オートスケール: 0〜1000インスタンスまで自動調整

- 従量課金: 実際の使用量に応じた課金

- 高可用性: マルチリージョン対応、自動フェイルオーバー

移行計画

- マイグレーション専用Dockerイメージ作成: Prisma DB初期化用

- VPC Connector構築: Cloud Run → Cloud SQL接続

- Secret Manager統合: APIキーのセキュアな管理

- 段階的な移行: 開発チーム → 全社展開

Phase 2の期待効果

- コスト: 月額$67程度(Phase 1比で約60%削減見込み)

- スケーラビリティ: 200名 → 500名以上まで対応可能

- 運用負荷: ほぼゼロ(自動管理)

- 信頼性: 99.95%(GCP SLA)

コスト比較: Phase 1 vs Phase 2(計画)

前提条件(中規模企業の例)

- 従業員数: 200名

- アクティブユーザー: 100名/日

- 平均リクエスト: 50回/人/日

- 合計リクエスト: 5,000回/日 = 150,000回/月

| 項目 | Phase 1: Preemptible VM | Phase 2: Cloud Run(計画) | 期待削減額 |

| Compute | |||

| VM (c2-standard-4) | $117.75/月 | - | - |

| Cloud Run (150K リクエスト) | - | $30.00/月 | ▼$87.75 |

| Database | |||

| Cloud SQL (db-f1-micro) | $11.07/月 | $11.07/月 | - |

| Cache | |||

| Memorystore Redis (1GB) | $35.77/月 | $35.77/月 | - |

| Network | |||

| VPC Connector / External IP | $0.41/月 | $0.41/月 | - |

| 合計 | **$165.00/月** | $77.25/月(見込み) | ▼$87.75 (53%削減見込み) |

利用規模別のコスト試算

| 月間リクエスト数 | Preemptible VM | Cloud Run(見込み) | 推奨構成 |

| 50,000(小規模) | $165 | $35 | Cloud Run |

| 150,000(中規模) | $165 | $77 | Cloud Run |

| 500,000(大規模) | $165 | $220 | 状況次第 |

| 2,000,000(企業規模) | $330(VM×2) | $650 | 要検討 |

構成選択のガイドライン

社内利用の規模や状況に応じた構成の選び方です。

Preemptible VMが適しているケース

- 試験導入期(2-3ヶ月の検証フェーズ)

- 月間200万リクエスト以上の大規模利用

- 24時間継続的な高トラフィック

- VMの直接管理が必要な特殊要件

Cloud Runが適しているケース

- 本番運用(コスト・運用負荷・スケーラビリティ重視)

- 月間200万リクエスト未満

- トラフィックの変動が大きい(夜間・週末は低利用)

- IT部門のリソースが限られている

- 今後の利用者増加が見込まれる

実装: Terraform IaCによる自動デプロイ

TerraformによるInfrastructure as Codeの実践により、再現可能なインフラ構築を実現しています。

プロジェクト構成

Plaintext

cl-litellm-terraform-github/

├── cl-litellm.tf # メインのTerraform設定

├── terraform.tfvars.example # 設定ファイルのサンプル

├── docker-v2/ # Cloud Run用Docker設定

│ ├── Dockerfile # LiteLLMコンテナ定義

│ ├── Dockerfile.migration # DB初期化用コンテナ

│ ├── config.yaml # LiteLLM設定ファイル

│ └── build-and-push.sh # ビルド&プッシュスクリプト

└── functions/ # Cloud Functions(VM自動復旧用)

└── vm-auto-restart/

デプロイの概要

Terraformを使用することで、以下のリソースを自動的に作成できます。

作成されるリソース

- Compute Engine VM(Phase 1)またはCloud Run Service(Phase 2)

- Cloud SQL(PostgreSQL)- ユーザー認証、利用履歴管理

- Memorystore for Redis - リクエストキャッシュ

- VPC Connector - プライベートネットワーク接続

- Secret Manager - APIキー、認証情報の安全な保管

- Cloud Functions - VM自動復旧(Phase 1)

- Firewall Rules - アクセス制御

Virtual Keyの管理

LiteLLMのダッシュボードまたはAPIを使用して、Virtual Keyを管理します。公式ドキュメントでは、/key/generateエンドポイントを使用してVirtual Keyを発行する方法が説明されています。

Virtual Key発行の基本フロー

- 管理者がマスターキーを使用してLiteLLMプロキシにアクセス

/key/generateエンドポイントでVirtual Keyを作成- ユーザー情報、予算、使用可能モデルを設定

- 生成されたVirtual Keyを従業員に配布

Virtual Keyには、ユーザーID、チームID、月次予算、使用可能モデルなどのメタデータを設定でき、きめ細かいアクセス制御が可能です。

運用のポイント

社内でLiteLLMを運用する際の重要なポイントを解説します。

Virtual Keyベースのアクセス管理

チーム別の設定例(2025年12月最新モデル対応)

| チーム | 月次予算 | 使用可能モデル | 用途 |

| 開発チーム | $500 | claude-opus-4.5, claude-sonnet-4.5, o3 | コーディング、高度な推論 |

| マーケティング | $200 | gpt-4.1-mini, gemini-3-flash, claude-haiku-4.5 | コンテンツ作成、画像生成 |

| カスタマーサポート | $300 | gpt-4.1-mini, claude-haiku-4.5 | FAQ対応、メール返信 |

| データサイエンス | $800 | claude-opus-4.5, o3, gpt-4.1 | データ分析、レポート生成 |

| 一般社員 | $50 | gpt-4.1-mini, claude-haiku-4.5 | 日常業務の効率化 |

Redis Cacheの活用

効果の測定例

- キャッシュヒット率: 約40-60%程度が期待できる

- コスト削減: 月額約30-50%の削減が見込める

- レスポンス速度: 平均200ms → 50ms程度(キャッシュヒット時)

利用状況の可視化

LiteLLMは自動的に以下の情報を記録します。

- リクエスト履歴(日時、ユーザー、モデル、コスト)

- Virtual Key別の利用状況

- チーム別のコスト集計

- エラー率とレイテンシ

これらのデータをもとに、月次レポートを作成し、コスト最適化や利用状況の分析に活用できます。

まとめ

本記事では、LiteLLMを使用した社内AIツールのAPIキー一元管理システムの構築方法を、クリエーションラインでの実践経験とともに解説しました。

クリエーションラインの導入アプローチ

段階的な移行戦略

- Phase 1: Preemptible VM(試験導入)

- 低コスト・低ハードルで素早くスタート

- 2-3ヶ月の検証で技術的な実現性を確認

- 自動復旧システムで99.9%の稼働率を達成

- Phase 2: Cloud Run(移行中)

- スケーラビリティと運用負荷削減を目指す

- 約60%のコスト削減を見込む

- フルマネージドで信頼性を向上

重要なポイント

- Virtual Keyによるセキュアな管理: プロバイダーAPIキーを従業員に露出させない

- 統一APIインターフェース: 従業員は単一のエンドポイントで全てのLLMにアクセス

- 利用状況の可視化: 誰が何を使ったか完全に記録

- 予算管理: Virtual Keyごとに月次予算を設定し、超過を防止

- 最新モデル対応: Claude 4.5シリーズ、GPT-4.1、Gemini 3 Flash等の最新モデルに対応

Terraformによる再現可能なインフラ

- Infrastructure as Codeの実践により、環境の再現性を担保

- Phase 1 → Phase 2の移行もコードで管理

- 災害復旧時の迅速な復元が可能

今後の強化の可能性

LiteLLMは以下のような機能をサポートしており、更なる強化が可能です。

1. マルチリージョン展開

LiteLLMはマルチリージョンアーキテクチャをサポートしており、地域ごとのインスタンスを展開することで、低レイテンシを実現できます。複数のLiteLLMインスタンスを異なるリージョンやAvailability Zoneにデプロイしながら、単一の管理ポイントで運用が可能です。

Plaintext

東京リージョン(asia-northeast1) └─ 日本・アジア太平洋地域の従業員向け ロンドンリージョン(europe-west2) └─ ヨーロッパ地域の従業員向け

主な利点:

- 地域ごとの低レイテンシアクセス

- 中央集権的な管理(設定、ユーザー、キー、モニタリング)

- コスト効率化(管理インフラの重複を回避)

2. 高度な利用分析

LiteLLMはLangfuseやHeliconeなどのLLM observabilityツールとの統合をサポートしています。success_callbackを設定するだけで、以下のような高度な分析が可能になります。

- プロンプトと応答の詳細記録

- A/Bテストによるプロンプト最適化

- モデル間のパフォーマンス比較

- ユーザーフィードバックの収集

- 使用状況、コスト、レイテンシの可視化

YAML

litellm_settings: success_callback: ["langfuse", "helicone"]

3. プロンプトライブラリ

LiteLLMはプロンプト管理機能をサポートしており、社内でよく使われるプロンプトをライブラリ化できます。GitOps方式のプロンプト管理では、.promptファイルとしてリポジトリに保存し、外部サービス不要で管理できます。

YAML

# プロンプトテンプレートの例

templates:

- name: "議事録要約"

prompt: "以下の議事録を3つの要点にまとめてください..."

model: "claude-haiku-4.5"

- name: "コードレビュー"

prompt: "以下のコードをレビューし、改善点を指摘してください..."

model: "claude-opus-4.5"

これにより、品質の標準化とコスト削減を図れます。

4. より高度なアクセス制御

LiteLLMはIPアドレスフィルタリングや時間ベースのアクセス制御をサポートしています。Virtual Keyと組み合わせることで、更なるセキュリティ強化が可能です。

- IPアドレス制限:

allowed_ips設定で社内ネットワークのみに制限可能 - 時間ベース制御: Virtual Keyの有効期限設定(

durationパラメータ)や予算期間(budget_duration)による制御 - 自動キーローテーション: 時間間隔に基づくVirtual Keyの自動ローテーション

YAML

general_settings: allowed_ips: ["192.168.1.0/24"] # 社内ネットワークのみ許可

これらの機能により、営業時間のみのアクセス制限やプロジェクト別のVirtual Key管理(プロジェクト終了時に一括無効化)などが実現できます。

おわりに

LiteLLMとTerraformを組み合わせることで、社内AIツールのAPIキー管理を一元化し、セキュアかつコスト効率の高い環境を構築できます。特にVirtual Key機能により、プロバイダーAPIキーを従業員に露出させることなく、柔軟なアクセス管理が可能になります。

2025年12月時点での最新モデル(Claude 4.5シリーズ、OpenAI o3/GPT-4.1、Gemini 3 Flash)にも対応し、常に最先端のAI技術を社内で活用できる環境を整えることができます。

推進体制について

本記事で紹介したLiteLLM導入の取り組みは、クリエーションラインのAI CoEを兼任しているAI & Data Engineering Teamのメンバーによって推進されました。AI & Data Engineering Teamは、主にAIプロダクト開発をメインとしたプロジェクトを手掛けており、LLM統合、AIエージェント開発、データ基盤構築など、幅広いAI活用の実践経験を持っています。

この体制により、以下のメリットが得られています。

- 実務経験に基づいた設計: 実際のAIプロダクト開発で必要な機能を理解した上での実装

- 迅速な問題解決: 技術的な課題に対して即座に対応可能

- 継続的な改善: 社内利用のフィードバックを元に、機能追加やチューニングを継続実施

この社内導入で得られた知見は、顧客企業でのAI活用支援にも活かされています。AIを活用したプロダクト開発、社内AI基盤の構築、LLM統合など、AI関連のご相談がございましたら、ぜひクリエーションラインにお問い合わせください。実践的な経験に基づいた支援を提供いたします。

参考リンク(2025年12月時点)

- LiteLLM公式ドキュメント: https://docs.litellm.ai/

- Virtual Keyドキュメント: https://docs.litellm.ai/docs/proxy/virtual_keys

- Terraform GCPプロバイダー: https://registry.terraform.io/providers/hashicorp/google/latest/docs

- Google Cloud Platform: https://cloud.google.com/

最新モデル公式ドキュメント

- OpenAI Models: https://platform.openai.com/docs/models

- Anthropic Models: https://docs.anthropic.com/en/docs/about-claude/models

- Google Gemini Models: https://ai.google.dev/gemini-api/docs/models